Mise à jour du capteur Red Dragon 6K (un goût de noël avant l’heure, mais après tout c’est l’Aïd)

Difficile de s’en tenir au seul « making of » comme annoncé dans le précédent billet lorsque Red annonce la sortie, ou plutôt la mise à jour de son capteur Dragon 6K. Alors voilà quelques détails techniques pour faire saliver ceux qui seraient sur les rangs pour passer ce cap réservé aux seules Epic, la Scarlet et en effet limitée dans cette mise à jour, à 5K pour un maximum de 60 ips, surement pour justifier des différences de prix et un placement marketing (je rappelle que les limitations de la Scarlet sont en effet purement liées au logiciel interne).

Tout d’abord le dernier né des capteurs de chez Red est donc un 6K 6144 (h) x 3160 (v), soit pour ceux qui auraient comme base du HD (1920×1080), 9 fois plus de résolutions. L’idée est simple, on se rapproche d’une part de la qualité du 35mm et surtout on a un format plus grand que celui de la diffusion qui semble se diriger vers le 4K aussi bien dans les salons que dans les meilleures salles de projection publiques.

Le capteur de 19 millions de pixels permettra même de filmer en 6k à une cadence de 100 images par secondes (120 ips à 5K, 200ips à 4k et 300ips à 2K), un peu comme si votre meilleur appareil photographique avait une fonction rafale de cette puissance (le mien ne fait guère mieux que 12 images par seconde) et que vous puissiez en plus éditer cela en tant que fichier vidéo Raw mais selon le codec R3d qui permet une compression pas inutile lorsque l’on passe à la gestion des fichiers en post-production.

comme l’on parle de procédé Raw et donc d’un traitement de l’image, de sa débayérisation non pas dans la caméra mais par un ordinateur il vous faudra aussi penser à investir dans une carte permettant ce calcul plus rapidement et pour cela Jannard le patron de Red a annoncé aussi une nouvelle RedRocket X cinq fois plus rapide que le premier modèle, ainsi qu’une version de RedCine-X Pro encore améliorée.

Pour en revenir aux détails techniques du capteur, il dispose et c’est là la vraie nouveauté et l’énorme amélioration d’une sensibilité efficace de 250 jusqu’à 2000 ISO et d’une plage dynamique de 16,5+ stops. en fait le capteur gagne plus de 3 stops de dynamique par rapport à son prédécesseur, un dans les hautes lumières et deux dans les noirs. L’avantage est que l’on peut se retrouver dans des situations extrêmes de contre jour ou de différentiel d’exposition dans une même scène sans pour autant perdre des informations dans les parties sombres ou trop éclairées.

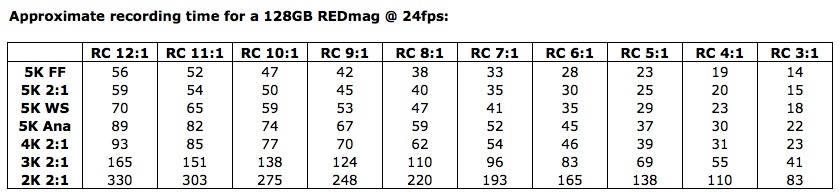

On pourra dès lors aussi pousser un peu plus la sensibilité en post production comme au tournage, selon les premiers essais il semble que des valeurs autour de 4000 ISO ne provoquent pas autant de bruit que l’on pourrait s’y attendre. Donc en parallèle on pourra aussi compresser un peu plus l’image mais obtenir un résultat comparable à une compression faible en utilisant le capteur MX. On parle ici d’une équivalence entre du 17:1 avec le Dragon et du 8:1 avec une Red MX sans affecter les teintes,les nuances, les noirs ou les blancs. On peut pousser cette compression de 3:1 à 18:1 en 12 ou 16 bit Raw.

La caméra (brain only) set annoncé à 29.000$ quand la mise à jour pour les possesseur d’Epic X ou M coutera un peu moins de 10.000$.

Comprendre le Raw, au début était la courbe de Gamma

De plus en plus de caméras « Raw » font leur apparition sur le marché, de quoi faire perdre la tête à pas mal de production, à quelques heures/jours/semaines/mois de la sortie tant attendue du capteur Dragon de chez Red. Voilà donc tout un petit billet pour s’y retrouver dans cette jungle révolutionnaire, on y parlera technique et courbe de Gamma dans un premier temps avant de faire un état des lieux de l’offre réelle de ce marché en question, pour voir ce que va changer la dernière née de chez Jim Jannard. Mais en guise d’introduction, après les déboires passagers de Aaton, me vient une nouvelle de mes amis de Ikonoskop qui annoncent arrêter un temps leur production, après maintes chutes des prix de leur petite caméra, les voilà peut être eux aussi face à un problème financier de trop.

A l’origine, le signal d’une télévision, et donc de sa capacité à recevoir de l’information par onde, nécessitait de réduire au maximum les informations produites par la « large » plage dynamique d’une image issue d’une caméra. Il faut comprendre que la bande passante transportant ces informations est limitée dès 1930 et dans les décennies qui suivent l’invention de la télévision hertzienne.

A chaque ouverture d’un diaph supplémentaire par exemple on double la luminosité par rapport au diaph précédent. Donc, en parallèle, on devrait doubler la bande passante requise pour transférer (ou enregistrer) le surplus d’information obtenu. Mais en pratique la bande passante n’évoluera pas, elle est en faite constante et déjà à son maximum.

La mauvaise qualité de cette méthode de transmission télévisée sans intervention aurait abouti à ne transmettre qu’une petite bande ou partie de cette plage dynamique de l’image.Le choix se porta donc, sur la réduction d’information. Et pour conserver une image diffusible et acceptable, on choisi de sacrifier les hautes lumières tendant ainsi à préserver les noirs et les tons moyens, ceux du visages. On comprendra qu’en télévision le plus important était donc le sujet et que l’on pouvait sacrifier l’arrière fond sans pour autant transformer dramatiquement l’image de base ainsi diffusée.

Voilà comment et pourquoi apparu la courbe gamma dont le travail consiste à préserver la lecture d’une image en réduisant les données des seules hautes lumières d’une image enregistrée ou diffusée, et donc en maitrisant la bande passante . Cette courbe s’ajuste au fur et à mesure de l’ouverture du diaph pour compenser cet afflux de données et donc faire disparaitre du même coup tout un tas d’informations dans les blancs, pourtant nécessaires à la lecture des éléments les plus clairs. Les noirs et les skintones, eux, ne sont pas vraiment concernés par l’opération et à force de s’habituer à ces amputations de l’image l’oeil finit par dire qu’il n’y voit pas de différence, bref, c’est diffusible sur le ondes.

Toutes les caméras vidéos utilisaient alors ce système de compression du signal qui empêchait y compris en post production de récupérer les informations perdus lors d’une surexposition sur un visage ou un ciel. Problème, les caméras gardaient le même système de compression et d’enregistrement alors même que leurs capteurs gagnaient eux en dynamique. Résultat, on perdait encore plus d’informations pour respecter la bande passante maximale du procédé d’enregistrement ou de diffusion. Paradoxalement plus les capteurs devaient restituer tout un plan des noirs au hautes lumières, plus on compressait ces dernières et plus le travail en post production devenait impossible du fait de la perte plus importante d’informations dans cette partie de l’image. On préférait donc une caméra ayant une moins grande dynamique d’image mais qui de fait la détruisait moins une fois gravée sur son support. Le mieux techniquement n’était pas l’ami du bien.

L’évolution nécessitait alors de se détourner ou de contourner cette courbe de Gamma afin de profiter pleinement des capacités des capteurs disposant de plus grandes plages dynamiques. C’est là qu’entre en jeu le filtre de Bayer (même si la technique aboutissant au Raw n’est pas limité à un seul type de capteur), il s’agit d’un seul capteur qui dispose d’un filtre lui permettant de reproduire le plus fidèlement possible les couleurs de l’image captée en bénéficiant de toute la dynamique de l’image.Le système consistant alors à convertir les informations de lumière en un signal vidéo couleur. Le processus multiplie l’information de lumière en la traitant pour chacune des couleurs primaires. La multiplication de traitement qu’opère ce filtre, composé de rouge, de vert et de bleu, n’est pas réalisée de manière égale en cela que les filtres verts sont deux fois plus présents que leurs homologues bleus ou rouges, afin de reproduire une image qui correspond le mieux à ce qu’un oeil naturellement.

Mais à nouveau après ce traitement arrive le problème de bande passante, car concernant un capteur de 4K, soit 4096×2160 pixels il faut enregistrer plus de 8 millions d’informations (8,8 millions pour être précis) à chaque image capturée. D’autant plus que si le traitement doit s’effectuer à ce moment là, il faudrait encore le répéter pour chacune des couleurs primaires qui divisent l’information et transforme la lumière en couleur. Soit un total après traitement de 26,5 millions d’informations par image.

L’idée du Raw suppose une simplification de ce traitement qui normalement vient en plus s’enrichir des ajustements fait par la caméra ou l’utilisateur au moment de l’enregistrement, tels les balances des blancs et les choix de gain qui pourtant n’affectent pas la manière de travailler pour le capteur. Car quelque soit le réglage utilisateur pour reproduire l’image qu’il voit et qu’il veut diffuser seul compte la quantité de lumière qui vient frapper le capteur et se transformer en signal vidéo couleur (RVB) qui sera ensuite modulé (ou mixé) en fonction du gain ou du degré Kelvin choisi et aboutira à une image plus ou moins bleu, verte ou rouge et plus ou moins « lumineuse » après traitement.

Le Raw consiste donc à ne pas traiter de la sorte le signal mais à le conserver dans l’état qu’il connait au sortir du capteur et donc à ne pas dé-Bayériser, et donc à ne pas utiliser une courbe Gamma. La somme de données informatiques est donc moins considérable que si l’on procédait à tout ces ajustements ou traitements, et permet de ne pas le « compresser ». Pour ce qui concerne les caméras, photo ou vidéo, dédiées au seul noir et blanc (Ikonoskop, Red, Leica M) là aussi le procédé consiste à simplifier le traitement en retirant le filtre de Bayer, qui nous l’avons compris ne sert qu’à injecter des informations de couleurs dans le traitement de la lumière reçue par le capteur. Cela rajoute du piqué et de la définition à l’image monochrome qui dispose de tous ses capteurs pour travailler sans être déformée par l’effet de Bayérisation. Le traitement étant extériorisé les premières Red ne pouvaient même pas relire leurs propres images, et l’utilisation d’une carte vidéo RedRocket est fortement conseillée pour pouvoir lire et transcoder ces images. Cependant les capteurs agrandissant leurs diagonales se voient aussi améliorés dans leurs capacités à capter les hautes lumières. en un mot il est maintenant utile d’avoir une très grande plage dynamique de l’image. C’est ce que le capteur Dragon de chez Red nous promet avec plus de 20 Stops de dynamique.

Pourtant on devra toujours passer par l’étape de dé-Bayerisation pour lire cette image, ce temps de traitement et de calcul est donc repoussé à plus tard. Mais on pourra aussi y ajuster le gain, ou la balance des blancs en fonction de ses propres choix. D’autant plus, rappelons le, que désormais on dispose des informations totales de l’image dans les noirs, les skintones ou les hautes lumières. Mais à ce niveau là il faudra encore choisir entre caméras disposant d’un très large capteur, celles proposant du Raw, ou du DNG, entre celles disposant d’un encodage parfois médiocre en interne mais offrant d’autres possibilités en externe, ou compressant de manière habile les fichiers afin de pouvoir réduire aussi les couts en post production, stockage et autres sans pour autant nuire réellement à l’image vue par un oeil humain. Le RedCode est le seul procédé connu et autorisé à ce jour qui permet de réduire les données de ces images Raw (Red est le seul à posséder la licence Raw pour la vidéo, les autres ne le font qu’à travers du CineDNG ou un « Raw » Maison comme Sony ou Arri. Il permet un taux de compression plus ou moins variable afin de ne pas se retrouver avec des Téra-octects de données pour un film de 5 minutes. On revient sur cela dans un prochain billet.

De quoi Aaton est-il le nom?

La France se targue d’être un grand pays de cinéma ou du cinéma selon que l’on aille jusqu’à penser qu’elle l’a inventé et qu’elle se situe au centre de ce monde. Pourtant c’est bien à l’écart de tout cela loin en périphérie que se trouve sa place en matière de développement et de fabrication de caméras ou d’enregistreur sonore.

Jean-Pierre Beauviala, ingénieur conseil chez Éclair-caméras fonda il y a quarante ans la société Aaton afin de proposer des caméras ergonomiques et de grande qualité ainsi que le Cantar un enregistreur numérique. Voilà pour l’histoire rapide, mais dernièrement Aaton tentait de sortir sa première caméra numérique en cherchant à proposer un matériel suivant le même cahier des charges que pour celles utilisant la pellicule. Beauviala désirant avec sa Pénélope-Delta, pouvoir rivaliser avec la qualité d’une image analogique et avouait que pour atteindre ce but il s’était tourné vers le meilleur capteur au monde. Le dispositif et la démarche semblent intéressants je vais donc les résumer ici. Tout d’abord le constructeur en question fut Dalsa, une entreprise canadienne spécialisée dans le domaine des capteurs et des semi-conducteurs, créée en 1980 et, propriété, depuis 2010 du groupe Teledyne Technologies. La sonde Curiosity et de nombreux satellites de la NASA sont en effet équipés de capteursDalsa restituant, parait-il, une colorimétrie parfaite nécessaire à la lecture des masses rocheuses de Mars.

Autre ajout technologique voulu par Aaton et qui en dit long sur leur philosophie, un procédé d’imitation de la pellicule et de sa manière de capter les photons. Le capteur numérique devait mimer les grains sensibles à la lumière grâce à un cadre en titane souple mais très robuste permettant un déplacement aléatoire du capteur à chaque image (de l’ordre de un demi pixel, qui est recalculé est donc corrigé par la suite). Pas de 3D, pas de capteur surdimensioné, pas de haute fréquence d’images par seconde, Aaton devait séduire son public sur la base de ces caméras argentiques et de son savoir faire en la matière. Beauviala défendait alors le cinéma comme une interprétation de la réalité et non pas comme une reproduction naturaliste.

Si Aaton est rentrée tardivement sur le marché du numérique c’est avant tout par amour de la pellicule, mais aussi parce que cette vision qualitative de l’image de cinéma entrainait forcément une critique acerbe mais étudiée de celle produite par les concurrents passés ou créé à l’ère numérique. Cette vision un peu passéiste Beauviala la revendiquait presque en affirmant que la « révolution numérique est venue par la projection en salles ». S’il ne se trompait pas dans son constat sur cette imposition et ses raisons par les grands studios il oubliait toutefois que avant de pouvoir être projeté ainsi le numérique existait en tant que caméra et que Dalsa par exemple proposait en 2006 déjà un engin capable de 4K. Qu’il ait voulu dès lors rentrer dans l’arène de cette révolution en cherchant à développer une caméra ergonomique et de qualité reste un point que l’on ne peut reprocher à Beauviala. Pour le reste c’est bien la recherche est développement qui a plongée Aaton dans le gouffre, car le problème vint du capteur en question qui a vouloir trop en faire n’était pas capable de restituer une image de qualité. La caméra numérique n’est pas (plus) une simple conversion d’un modèle argentique en un modèle sur lequel on a placé un capteur mais bien une conception à part entière avec un cahier des charges bien précis. Et c’est donc ces choix techniques qui aujourd’hui coutent à Aaton d’être placée en redressement judiciaire.

Aaton est donc le nom d’un concept « du chat sur l’épaule » concurrencé par des usines à gaz numérique, véritable jeu de mécanos très dur à équilibrer et à aimer en tant qu’objet. Des caméras au large capteur qui encode parfois en 8bits , mais les productions ne se posent pas ce genre de questions, et qui à l’air de couter si peu que tout le monde à en une au fond d’un tiroir. Aaton est le nom de la fin d’une époque, celle de la pellicule et des laboratoires notamment en France. Aaton est le nom d’une industrie qui en passant au numérique à tout prix, le fait surtout sur le dos de la qualité. Aaton est le nom d’un monde où il est dur de trouver désormais de la pellicule pour des projets et des caméras alternatifs. Aaton est le nom d’une jolie société qui a pensé que si elle savait faire (plutôt bien) des caméras elle passerait sans problème à la commercialisation d’un modèle numérique mais qui a du se rendre à l’évidence que son fournisseur de capteurs, lui n’était pas à la hauteur, mais un peu trop tard. Aaton est le nom qu’on aimait bien d’un temps où l’on connaissait encore le nom de l’ingénieur qui développait le matériel qu’on utilisait avec plaisir, aussi parce qu’il avait de la gueule et que le résultat, après développement se projetait sur un bel écran dans un format un peu plus beau et grand que le 2 ou 4K que notre salon accueillera l’année prochaine.

Le Cinéma français qui s’offusque des salaires de ses acteurs, qui comprend mal comment un projet largement financé par ailleurs vient tout de même quémander une participation des internautes pour boucler son budget, et dans notre cas qui ne comprend pas pourquoi le troisième pays du cinéma n’est pas capable de proposer une caméra française, devrait surtout se poser la question du modèle économique de son industrie et de sa capacité à investir dans la recherche et le développement et à soutenir une industrie de pointe. Aaton reste viable souhaitons leur le meilleur et de traverser cette crise (une de plus) pour enfin nous délivrer leur projet de petite caméra numérique de documentaire visé reflex type A-Minima c’est le plus grand mal que l’on se souhaite.

Loin de cette ambiance de fin de séance dans un tribunal qui jugera de la faisabilité et du projet du futur repreneur de Aaton je voulais profiter de ce billet pour vanter les qualités d’un petit produit simpliste néozélandais d’origine que j’ai adopté pour les timelapses que je devais réaliser avec un appareil photographique reflex numérique.

Le Syrp c’est son nom, combine un moteur capable de rotation à 360° ou de travelling le long d’une petite cordelette et un cerveau-logiciel, capable de communiquer avec n’importe quel hdslr du marché afin de déclencher l’appareil après chaque mouvement à la vitesse voulu par l’utilisateur. Un petit compagnon idéal pour les pans parfaits et les travellings impossibles, la caméra fixée sur un simple skateboard tracté par une corde attachée à un arbre…

Vous l’aurez compris on est loin de la technicité du capteur Dalsa dont on parlait plus haut, mais, la robustesse et le plaisir de se construire des plateformes que l’on pourra rendre mobile grâce à ce petit boitier qui va piloter lui même le timelapse donne envie d’aller vous poser au bord d’un beau paysage après quelques construction de mécanos et de lancer l’enregistrement en Raw et pourquoi pas en HDR (si vous avez la patience de combiner, fusionner et ajuster autant d’images nécessaires à votre film). Voilà à quoi je passe mon temps en ce moment même. Un grand merci à Syrp pour leur petite invention sans prétention dont j’espère pouvoir vous faire un compte rendu complet au cours d’un tournage à venir. Aller à la pêche aux informations sur leur site vous tomberez sous le charme.

Autopromotion

Je profite du NAB 2013 pour faire un peu d’autopromotion du travail que j’ai pu effectuer ces derniers temps notamment pour des télévisions et clients au Moyen Orient mais aussi en Europe. Ces images proviennent de quelques beaux voyages à Singapour avec Benny Ong, à Jakarta, en Europe du nord ou de l’est, à Paris pour des timelapses , au Liban, dans des camps de réfugiés avec l’UNRWA et jusque sur quelques plages Cannoises aussi avec Clémence Poesy. Dans le déluge d’annonce du salon mondial de Las Vegas dont je promets de faire prochainement un petit compte rendu et une analyse des tendances voilà un peu de nostalgie et un retour sur un peu plus d’un an de travail et de rencontres.

Vous devez être connecté pour poster un commentaire.